El sistema universal para infraestructuras de IA

NVIDIA DGX A100 es el sistema universal para todas las cargas de trabajo de IA, ofreciendo una densidad de computación sin precedentes, y flexibilidad en el primer sistema del mundo con 5 petaFLOPS AI. Se compone de los aceleradores más avanzados del mundo, las GPU Nvidia A100 Tensor Core, permitiendo a las empresas consolidar el entrenamiento, la inferencia y las analíticas en una infraestructura de Inteligencia Artificial unificada y fácil de desplegar que incluye el acceso directo a expertos en IA de Nvidia. Se entrega instalado con el sistema operativo DGX OS, afinado para cargas de trabajo de IA, con todo el software necesario y librerías de Nvidia ya incluido, licenciado e instalado. Así mismo, se incluye soporte telefónico 24×7 directo con los expertos DGX de NVIDIA.

El sistema universal para cada trabajo de IA

Nvidia DGX A100 es el sistema universal para toda la infraestrucura IA, desde analítica hasta inferencia y entrenamiento. Marca un nuevo récord para la densidad de cómputo, empaquetando 5 petaFLOPS de rendimiento AI en un tamaño de 6U, reemplazando los silos de infraestructura obsoleta con una plataforma para cada carga de trabajo AI.

Expertos DGX: acceso integrado a la experiencia IA

Los expertos DGX de Nvidia son un grupo global de más de 16.000 profesionales con conocimientos de IA, quienes han creado un pozo de experiencia durante la última década para maximizar el valor de su inversión DGX.

El menor tiempo para la solución

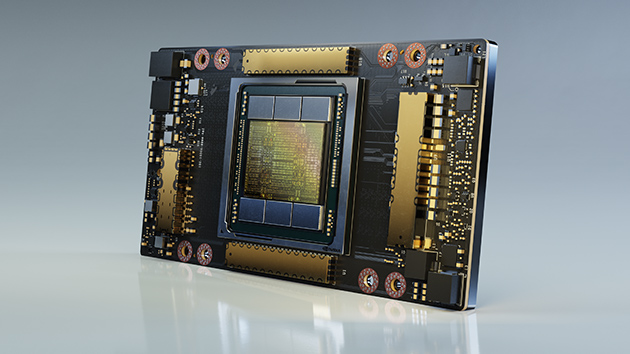

Nvidia DGX A100 es el primer sistema del mundo construido sobre las GPU Tensor Core. Integrando ocho GPU A100 con hasta 640GB de memoria GPU, el sistema proporciona una aceleración sin precedentes y está completamente optimizada para el software Nvidia CUDA-X y el paquete de soluciones completo Nvidia Data Center.

Escalabilidad Data Center sin precedentes

Nvidia DGX A100 integra adaptadores de red Mellanox ConnectX-6 VPI HDR Infiniband/Ethernet con 500 gigabytes por segundo (GB/s) de ancho de banda bi-direccional. Esta es una de las múltiples características que hacen de la DGX A100, la plataforma fundacional para largos clusters de IA como Nvidia DGX SuperPOD.

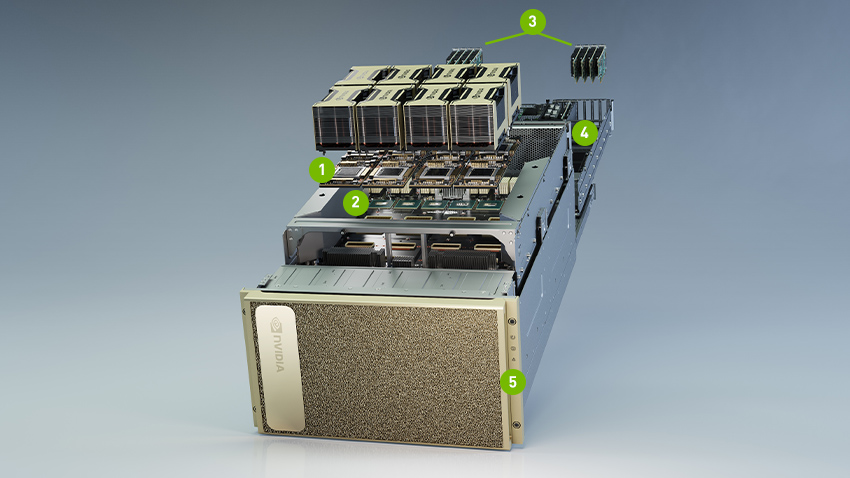

EXPLORE LOS POTENTES COMPONENTES DEL DGX A100

- 8 GPU NVIDIA A100 hasta 640GB de memoria 12NVLinks/GPU, ancho de banda bi-direccional 600GB/s GPU-a-GPU

- 6 NVIDIA SWITCHES 4.8TB/s de ancho de banda bi-direccional, x2 más que la anterior generación

- 10 Interfaces de red Mellanox ConnectX-6 200 Gb/s Ancho de banda de 500 GB/s bi-direccional

- CPU dual AMD 64 cores y 2TB de memoria RAM x3.2 veces más cores

- 30TB GEN4 NVME SSD Ancho de banda 50 GB/s, x2 más rápido que GEN 3 NVME SSD

DGX STATION

- DataCenter in a Box en formato torre

- 5petaFLOPS de rendimiento

- Enchufar y listo, no requiere infraestructura DataCenter

- Refrigeración líquida ultrasilenciosa <37dB

- 4 GPU A100 hasta 320GB de memoria

- 64 cores hasta 3.4 GHz y 512GB de memoria RAM

- Doble puerto 10Gb base-T

- 7.68TB NVMe SSD GEN4

- 4 salidas Mini DisplayPort

- Consumo 1.500kw

DGX OS

Los sistemas DGX de NVIDIA vienen preinstalados y optimizados para cargas de trabajo de Inteligencia Artificial. Se incluyen todas las licencias necesarias para su uso intensivo, las características más destacadas son:

- Distribución Ubuntu server con paquetes de soporte

- El siguiente software de gestión del sistema y monitorización:

– NVIDIA System Management (NVSM). Proporciona monitorización activa de la salud y alertas del sistema para los nodos DGX, y comandos simples para comprobar el estado del sistema DGX A100 desde la línea de comandos.

– Data Center GPU Management (DCGM). Este software permite la administración de las GPUs a través de los nodos y puede usarse para la gestión de clusters a nivel Data Center. - Paquetes de soporte del sistema DGX A100

- El controlador o “driver” NVIDIA GPU

- Motor Docker

- NVIDIA Cointainer Toolkit

- Mellanox OpenFabrics Enterprise Distribution for Linux (MOFED)

- Mellanox Software Tools (MST)

- Drivers Mellanox para usar RDMA over Infiniband

- Cachefilesd (daemon para gestionar los datos de la caché de almacenamiento

- Software de partición de GPUs Multi-Instance GPU (MIG), que permite que la NVIDIA A100 sea particionada de forma segura en hasta 7 instancias GPU separadas

- Mejoras de seguridad para mitigar vulnerabilidades especulativas de la CPU

- Incluye un script para gestionar la característica de Crash Dump

- Software de gestión de discos auto encriptables (Self Encrypting drive SED) que permite establecer una clave de autenticación para bloquear y desbloquear los discos de datos del DGX A100 ante la pérdida de electricidad o extracción no autorizada

- Trusted Platform Module (TPM) que permite guardar la clave de autenticación de forma persistente si el sistema se reinstala

- Registro privado a NVIDIA GPU Cloud (NGC), para el uso de aplicaciones contenerizadas de aplicaciones de deep learning, machine learning y HPC aceleradas por GPU

- Secure Flash está implementado en los DGX A100 para prevenir el flasheado de firmware sin verificar y sin firmar

- Herramientas de estrés para comprobar el perfecto funcionamiento del sistema

SERVICIOS DE POSTVENTA Y MANTENIMIENTO

Las prestaciones clave y servicios más destacados son:

- Mantenimiento preventivo, correctivo y evolutivo, incluyendo CUDA Runtime, las bibliotecas aceleradas por GPU, las herramientas SDK, frameworks optimizados, el software y firmware del sistema (controladores) y el material y acceso completo al repositorio de contenedores en cloud de Nvida y software de dockerización.

- Ante el evento de defectos en material o mano de obra del hardware bajo circunstancias de uso normales, envío de la pieza de recambio en el siguiente día laborable a la autorización de devolución del material (RMA) y puede tener lugar antes del retorno a Nvidia del material defectuoso.

- A discreción de Nvidia, como parte del servicio de RMA, Nvidia puede ofrecer a enviar a técnicos de soporte on site para el diagnóstico, soporte y para las reparaciones de hardware o recambio, sujeto a la disponibilidad de técnicos en el área geográfica. Mano de obra y desplazamientos incluidos.

- Comunicación directa con arquitectos de soluciones expertos de NVIDIA en plataformas DGX.

- Soporte de ciclo de vida de software NVIDIA DGX Systems.

- Servicios de soporte hardware remoto que incluyen herramientas de diagnóstico para una detección preventiva de problemas de funcionalidad.

- Portal de soporte online 24×7 con acceso a herramientas de seguimiento para el reporte de bugs y resolución de incidencias, materiales de la base de datos de conocimientos e información para la resolución de problemas

- Call center telefónico 24×7 para servicio de soporte (en inglés)

- Asistencia técnica telefónica en horario laboral de 8am a 5pm en tiempo local, donde los técnicos asistirán la resolución de problemas.

- Acceso al servicio de suscripción de soporte de software para el software soportado instalado de fábrica (incluye soporte técnico, mantenimiento, actualizaciones y mejoras)

- Acceso a servicios para ciertos contenedores de Nvidia y modelos disponibles en Nvidia GPU Cloud, incluyendo la gestión privada y compartición de imágenes personalizadas.

Los términos y condiciones completos se pueden consultar en:

https://images.nvidia.com/content/technologies/deep-learning/pdf/DGX-Services-TCs-20210310.pdf

Se puede consultar el acuerdo de licencia de usuario final (EULA) en: